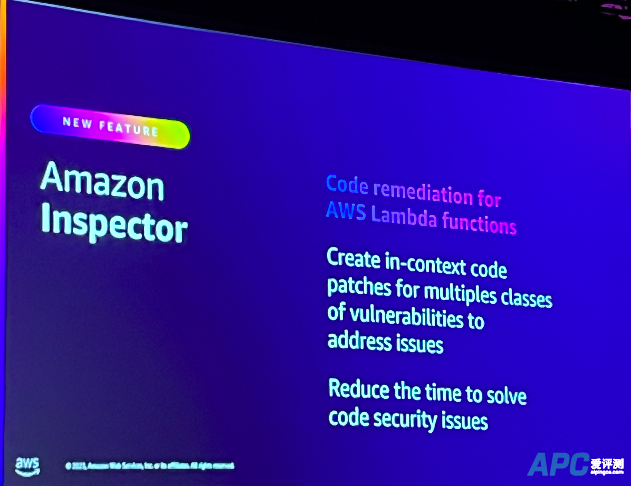

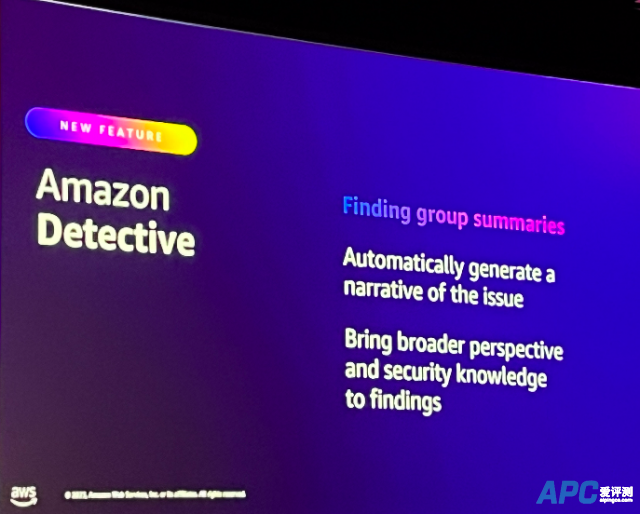

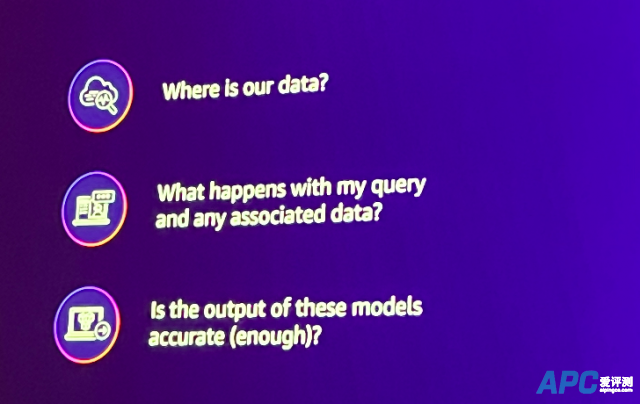

[aipingce]12月4日消息,麦肯锡最新研究表明,GenAI(Generative AI,生成式AI)每年对全球经济的贡献将达7.9万亿美元。GenAI不仅对全球经济产生重要影响,也为各个行业带来变革机遇。 随着GenAI在各行各业的影响力更加深入,关于GenAI的安全性问题也受到更多关注。 在亚马逊云科技在2023 re:Invent全球大会上,亚马逊首席安全官Steve Schmidt从两个角度阐述了GenAI和LLMs(Large Language Models,大型语言模型)与企业信息安全之间的关系。  亚马逊首席安全官Steve Schmidt Steve Schmidt一方面强调,LLMs和GenAI是帮助安全人员改善安全成果的最新工具;另一方面,他又对如何安全使用GenAI服务提出了经典的“三连问”,并通过自答的方式,细致阐述了亚马逊云科技在打造GenAI服务时如何确保服务的安全性。 把GenAI作为工具,改善提效安全人员工作 和其他行业一样,在安全领域,LLMs和GenAI可以帮助安全人员改善、提效安全工作,Steve Schmidt表示,GenAI就是亚马逊团队用来帮助客户更有效地工作、同时提高安全标准的又一种工具。 在2023 re:Invent上,Steve Schmidt正式宣布,亚马逊推出了2款GenAI驱动的安全服务新功能。 新功能一:Amazon Inspector的新功能使用机器学习模型和自动推理来帮助用户识别代码漏洞,并提供修复漏洞的代码补丁的指导。开发人员验证了Amazon Inspector所提议的代码功能符合要求之后,就可以合并代码,快速有效地解决安全问题。  Steve Schmidt向TechWeb强调,GenAI驱动的Amazon Inspector能做的不止是指出不正确的代码,并且还会直接给出开发者所需要的正确代码。这是一个非常强大的能力,可以加速开发者的速度,也能训练他们如何编写安全的代码。 新功能二:Amazon Detective的新功能是一项调查潜在安全问题的服务能力,可帮助客户分析、调查并快速确定安全发现或可疑活动的根本原因。  Amazon Detective使用GenAI来创建关于安全威胁或入侵的技术指标的文本描述,人类工程师的角色则是确认机器的分析是否正确,这样可以帮助安全工程师提高工作效率,让他们更高效,且更享受他们的工作。在以前,这项工作需要具备特定专业知识的安全工程师才能完成,他们需要手动编写报告并详细说明发生了哪些事情。 Steve Schmidt强调,“亚马逊的所有代码在进入生产阶段之前都要经过审查,多年来我们进行的大量代码审查和庞大的代码库规模使我们能够有效地训练和精细调整这个模型服务,最近亚马逊开始使用定制的大型语言模型来加速代码审查。” 如何安全的使用GenAI服务? 随着人工智能的每一次创新,都会出现新的挑战和机遇。对于安全团队来说,帮助企业理解这些创新飞跃带来的利益和风险是非常重要的。 “当业务部门确定AI将帮助他们实现特定目标时,有三个重要问题有助于塑造安全需求与业务工作流的一致性。我建议你们在自己的环境中考虑这三个问题。”Steve Schmidt表示。  问题一:“Where is our data ?”(我们的数据在哪里?) Steve Schmidt将这个问题进一步进行了拆解:如果你正在用你的公司数据训练大型语言模型,模型是如何访问那些数据的?在训练过程中,你能否保持数据在传输和静止时的加密,以及你如何验证这一点正在发生?用于访问该数据的权限是否已被限制为尽可能最少? 你和你的团队还需要探索你们正在使用的模型的隔离级别。如果你为了获得更相关的结果而向模型提供公司数据,其他人是否能够看到你数据的片段? 问题二:“What happens with my query and with any associated data?”(当查询和任何相关数据会发生什么?) “查询本身也可能是敏感的,应该是你的数据保护计划的一部分。”Steve Schmidt强调。 当用户开始向GenAI大型语言模型提问时,他们发出的查询中往往会添加更多细节和具体要求,这会带来更好的结果。但是,如果你的员工查询了AI聊天机器人,那么这次查询的输出和员工对结果的反应,是否也会被用于训练模型? 问题三:Is the output of the generative AI models accurate enough? (GenAI模型的输出是否足够准确?) Steve Schmidt指出,大型语言模型生成“非确定性”的输出,这是该技术的一个重要特征。 大模型可以识别大量不同的问题,其中一些问题可能是工程师没有注意到的;大模型也可能无法识别每个可能的安全问题,因此不能成为唯一识别问题的方式。要理解GenAI的局限性。 “如果有人告诉你他们的GenAI能力可以完全替代你的安全工程师,请保持怀疑。” Steve Schmidt说道,安全团队不能将所有决策权交给AI,更合适的方法是,用大模型帮助有才华的工程师更有效率、更有效地工作。 “这三个问题:‘我们的数据在哪里?’、‘我的查询及相关数据会发生什么?’、‘这些模型的输出是否足够准确?’指导了我们的安全团队如何思考GenAI和大语言模型服务,以及亚马逊内部业务人员使用这些工具的方式。”Steve Schmidt总结道:“任何一家企业在使用GenAI服务时都要搞清楚这3个问题。在我们看来,客户应该控制自己的数据并能够以安全可靠的方式使用自己选择的模型。这也是Amazon Bedrock为客户提供私有定制基础模型的原因。” 据介绍,亚马逊云科技提供的Amazon Bedrock有两个组成部分,底层基础模型,它是在大量数据上训练的,但它不一定适合于所在企业的工作方式。所以通过定制化能力,让企业客户用自己的训练数据来微调模型,这个训练内容是企业自己的,不会被放回基础模型中,也不会与第三方模型开发者共享。 Amazon Bedrock是亚马逊云科技于今年4月发布的一项全面托管的服务,通过它,企业用户可以通过API等方式轻松访问包括亚马逊云科技自研的Titan系列模型和众多主流第三方大模型。截至目前,Amazon Bedrock提供的基础模型包括Amazon Titan的5款模型、Anthropic Claude 2.1、Meta Llama 2 70B、Stability AI Stable Diffusion XL 1.0、Meta Llama 2 Chat 13B、Cohere Command Light、Cohere Embed English和Cohere Embed多语言模型等。 |